¿Qué es la Mecánica Cuántica?

.

Por: Oswel Albarran

2. Teorías de la mecánica cuántica

3. Historia de la mecánica cuántica

4. Principales autores de la mecánica cuántica

5. Aplicaciones de la mecánica cuántica

6. Conclusión.

.

Introducción

.

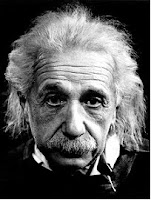

Cuando se habla de personas influyentes, uno siempre piensa en los gobernantes o en los políticos. Sin embargo el impacto que ha tenido el descubrimiento de la Mecánica Cuántica en nuestro quehacer diario es tan formidable que es dable pensar que los científicos que contribuyeron a su desarrollo, son las personas que más influyen actualmente en nuestras vidas. Nombres desconocidos como Bohr, Heisenberg, Schrödinger, Pauli, Bardeen, Oppenheimer, Gabor, Schockley, Brattain, Roentgen, Dirac, etc. y el único muy conocido Einstein, han cambiado el mundo completamente.

A principios del siglo XX se produjo en el mundo una verdadera revolución científica en el campo de la física, la que respondió a la inquietud del hombre por conocer la estructura de la materia, es decir saber cuales son sus componentes primarias. Ya los griegos habían pensado que estaba formada de pequeñas esferas que ellos denominaron átomos. Pero hasta entonces se trataba sólo de una conjetura. El descubrimiento de los rayos X en 1900 or Roentgen (primer Premio Nobel en Física), permitió tener las primeras evidencias de su existencia.

En las décadas iniciales del siglo pasado se realizaron muchos experimentos tendientes a dilucidar numerosas interrogantes respecto a la naturaleza de los átomos y sus constituyentes. Estos experimentos generaron una gran cantidad de datos. Sin embargo la recolección de resultados experimentales no basta en el trabajo científico. Para hacerlos valederos es necesario tener una visión global y coherente del fenómeno en estudio. Es lo que en la ciencia se llama una teoría. La Mecánica Cuántica es la teoría que por primera vez permitió entender el mundo microscópico de la materia, es decir él de los átomos. Fue el resultado del trabajo intelectual de físicos como Bohr, Einstein, Heisenberg, Schrödinger, Dirac y otros.

Durante esta época no solo hubo una gran revolución en el campo de la ciencia, pero también el mundo estaba pasando por grandes cambios históricos como la revolución rusa, la primera y segunda guerras mundiales. Las consecuencias de la mecánica cuántica podrían haber completamente cambiado el mundo tal como lo conocemos ahora. Una de las consecuencias casi inmediatas de la mecánica cuántica es que ciertos átomos como el Uranio-235 se pueden fisionar (“quebrar”) si un neutrón (una partícula subatómica) choca con el. Cuando esto ocurre, se liberan un gran cantidad de energía y dos neutrones. En turno cada uno de estos neutrones choca con otro átomo de Uranio-235, libera energía y dos neutrones más. Esto es lo que se llama una “reacción en cadena” y da origen a una terrible arma: la bomba atómica.

.

Teorías de la Mecánica Cuántica.

.

La mecánica cuántica conocida también como mecánica ondulatoria en alguna de sus interpretaciones es una de las ramas principales de la física que explica el comportamiento de la materia y de la energía. Su campo de aplicación pretende ser universal (salvando las dificultades), pero es en el mundo de lo pequeño donde sus predicciones divergen radicalmente de la llamada física clásica.

De forma específica, se considera también mecánica cuántica, a la parte de ella misma que no incorpora la relatividad en su formalismo, tan sólo como añadido mediante teoría de perturbaciones. La parte de la mecánica cuántica que sí incorpora elementos relativistas de manera formal y con diversos problemas, es la mecánica cuántica relativista o ya, de forma más exacta y potente, la teoría cuántica de campos que incluye a su vez a la electrodinámica cuántica, cromodinámica cuántica y teoría electrodébil dentro del modelo estándar y más generalmente, la teoría cuántica de campos en espacio-tiempo curvo. La única inter cción que no se ha podido cuántificar ha sido la interacción gravitatoria.

La mecánica cuántica es la base de los estudios del átomo, los núcleos y las partículas elementales siendo ya necesario el tratamiento relativista pero también en teoría de la información, criptografía y química.

Conviene anotar que La física es una ciencia natural que estudia las propiedades del espacio, el tiempo, la materia y la energía, así como sus interacciones. La misma demuestra que la Materia es todo aquello que ocupa un lugar en el espacio y En física, la energía es aquella con capacidad para realizar un trabajo, tambien se refiere a un recurso natural y la tecnología asociada para explotarla y hacer un uso industrial o económico del mismo.

La mecánica cuántica tiene como conceptor La espuma cuántica, también llamada como espuma espaciotemporal, concebido por John Wheeler en 1955, se utiliza el término como una descripción cualitativa de las turbulencias del espacio-tiempo subatómico, que tienen lugar a distancias extremadamente pequeñas, del orden de la longitud de Planck. En esta escala de tiempo y espacio, el principio de incertidumbre permite que las partículas y la energía existan brevemente, para aniquilarse posteriormente, sin violar las leyes de conservación de masa y energía. Sin embargo esta no esta completa con la teoría de gravedad cuántica ya que está procura unificar la teoría cuántica de campos, que describe tres de las fuerzas fundamentales de la naturaleza, con la relatividad general, la teoría de la cuarta fuerza fundamental: la gravedad. La meta es lograr establecer una base matemática unificada que describa el comportamiento de todas las fuerzas de las naturalezas, conocida como la Teoría del campo unificado.

No obstante explica que una onda es una propagación de una perturbación de alguna propiedad de un medio, por ejemplo, densidad, presión, campo eléctrico o campo magnético, que se propaga a través del espacio transportando energía. El medio perturbado puede ser de naturaleza diversa como aire, agua, un trozo de metal, el espacio o el vacío.

Obviamente como está la física cuántica también interfiere La química cuántica que simplemente es la aplicación de la mecánica cuántica a problemas de química. Una aplicación de la química cuántica es el estudio del comportamiento de átomos y moléculas, en cuanto a sus propiedades ópticas, eléctricas, magnéticas y mecánicas, y también su reactividad química, sus propiedades redox, etc., pero también se estudian materiales, tanto sólidos extendidos como superficies.

Pero a pesar de todos estos factores uno de los mas importantes serian la Teoría de la Relatividad la cual se engloban generalmente dos cuerpos de investigación en ciencias físicas, usualmente conectadas con las investigaciones del físico Albert Einstein: su Teoría de la Relatividad Especial y su Teoría de la Relatividad General.

La primera, publicada en 1905, trata de la física del movimiento de los cuerpos en ausencia de fuerzas gravitatorias. La segunda, de 1915, es una teoría de la gravedad que reemplaza a la gravedad newtoniana pero se aproxima a ella en campos gravitatorios débiles. La teoría especial se reduce a la general en ausencia de campos gravitatorios. Esta teoría esta presente en la mecánica cuántica como uno de sus riegos y ventajas mas delicados e importantes.

Para describir la teoría de forma general es necesario un tratamiento matemático riguroso, pero aceptando una de las tres interpretaciones de la mecánica cuántica (a partir de ahora la Interpretación de Copenhague) el marco se relaja. La Mecánica cuántica describe el estado instantáneo de un sistema (estado cuántico) con una función de onda que codifica la distribución de probabilidad de todas las propiedades medibles, u observables. Algunos observables posibles sobre un sistema dado son la energía, posición, momento y momento angular. La mecánica cuántica no asigna valores definidos a los observables, sino que hace predicciones sobre sus distribuciones de probabilidad. Las propiedades ondulatorias de la materia son explicadas por la interferencia de las funciones de onda.

Estas funciones de onda pueden variar con el transcurso del tiempo. Esta evolución es determinista si sobre el sistema no se realiza ninguna medida aunque esta evolución es estocástica y se produce mediante colapso de la función de onda cuando se realiza una medida sobre el sistema (Postulado IV de la MC). Por ejemplo, una partícula moviéndose sin interferencia en el espacio vacío puede ser descrita mediante una función de onda que es un paquete de ondas centrado alrededor de alguna posición media. Según pasa el tiempo, el centro del paquete puede trasladarse, cambiar, de modo que la partícula parece estar localizada más precisamente en otro lugar. La evolución temporal determinista de las funciones de onda es descrita por la Ecuación de Schrödinger.

Algunas funciones de onda describen estados físicos con distribuciones de probabilidad que son constantes en el tiempo, estos estados se llaman estacionarios, son estados propios del operador hamiltoniano y tienen energía bien definida. Muchos sistemas que eran tratados dinámicamente en mecánica clásica son descritos mediante tales funciones de onda estáticas. Por ejemplo, un electrón en un átomo sin excitar se dibuja clásicamente como una partícula que rodea el núcleo, mientras que en mecánica cuántica es descrito por una nube de probabilidad estática que rodea al núcleo.

Cuando se realiza una medición en un observable del sistema, la función de ondas se convierte en una del conjunto de las funciones llamadas funciones propias o estados propios del observable en cuestión. Este proceso es conocido como colapso de la función de onda. Las probabilidades relativas de ese colapso sobre alguno de los estados propios posibles es descrita por la función de onda instantánea justo antes de la reducción. Considerando el ejemplo anterior sobre la partícula en el vacío, si se mide la posición de la misma, se obtendrá un valor impredecible x. En general, es imposible predecir con precisión qué valor de x se obtendrá, aunque es probable que se obtenga uno cercano al centro del paquete de ondas, donde la amplitud de la función de onda es grande. Después de que se ha hecho la medida, la función de onda de la partícula colapsa y se reduce a una que esté muy concentrada en torno a la posición observada x.

La ecuación de Schrödinger es en parte determinista en el sentido de que, dada una función de onda a un tiempo inicial dado, la ecuación suministra una predicción concreta de qué función tendremos en cualquier tiempo posterior. Durante una medida, el eigen-estado al cual colapsa la función es probabilista y en este aspecto es no determinista. Así que la naturaleza probabilista de la mecánica cuántica nace del acto de la medida.

Asi mismo La ley de gravitación universal, presentada por Isaac Newton en su libro publicado en 1687, "Philosophiae Naturalis Principia Mathematica" establece, la forma y explica el fenómeno natural de la atracción que tiene lugar entre dos objetos con masa.

Todo objeto en el universo que posea masa ejerce una atracción gravitatoria sobre cualquier otro objeto con masa, independientemente de la distancia que los separe. Según explica esta ley, mientras más masa posean los objetos, mayor será la fuerza de atracción, y paralelamente, mientras más cerca se encuentren entre sí, será mayor esa fuerza.

Las ecuaciones de Maxwell son un conjunto de cuatro ecuaciones que describen por completo los fenómenos electromagnéticos. La gran contribución de James Clerk Maxwell fue reunir en estas ecuaciones largos años de resultados experimentales, debidos a Coulomb, Gauss, Ampere, Faraday y otros, introduciendo los conceptos de campo y corriente de desplazamiento, y unificando los campos eléctricos y magnéticos en un solo concepto: el campo electromagnético. después de los últimos años, ha sido conformada principalmente de la química cuantica, por ejemplo, en la aplicación de mecánica cuantica a problemas de Química. La Química teórica se puede dividir ampliamente en ramas como estructura electrónica, dinámica, y mecánica estadística.

En el proceso de resolver los problemas de predecir la relatividad química, todos los procesos anteriores pueden ser usados en diferente profundidad. Otras áreas "variadas" en la química teórica incluyen la caracterización matemática de la química "bruta" in varios estadios “por ejemplo en el estudio de la cinética química y el estudio de la aplicación de los más recientes desarrollos matemáticos a las áreas básicas de estudio “como por ejemplo, la posible aplicación de los principios de topología al estudio de la estructura electrónica”. La última área desarrollada en la química teórica es normalmente llamada química matematica.

.

Por otra parte se puede decir:

,

La mecánica cuántica, -también física cuántica-, es la ciencia que tiene por objeto el estudio y comportamiento de la materia a escala reducida.

El concepto reducido se refiere aquí a tamaños a partir de los cuales empiezan a notarse efectos como el principio de indeterminación de Heisenberg que establece la imposibilidad de conocer con exactitud, arbitraria y simultáneamente, la posición y el momento de una partícula. Así, los principios fundamentales de la mecánica cuántica establecen con mayor exactitud el comportamiento y la dinámica de sistemas irreversibles. Los efectos sobre la materia son notables en materiales mesoscópicos, aproximadamente 1.000 átomos de composición.

Algunos fundamentos importantes de la teoría son que la energía no se intercambia de forma continua. En todo intercambio energético hay una cantidad mínima involucrada, llamada cuanto.

Si aceptamos el hecho de que es imposible fijar a la vez la posición y el momento de una partícula, renunciamos de alguna manera al concepto de trayectoria, vital en mecánica clásica. En vez de eso, el movimiento de una partícula queda regido por una función matemática que asigna, a cada punto del espacio y a cada instante, la probabilidad de que la partícula descrita se halle en una posición determinada en un instante determinado (al menos, en la interpretación de la Mecánica cuántica más usual, la probabilística o interpretación de Copenhague). A partir de esa función, o función de ondas, se extraen teóricamente todas las magnitudes del movimiento necesarias.

Aunque la estructura formal de la teoría está bien desarrollada, y sus resultados son coherentes con los experimentos, no sucede lo mismo con su interpretación, que sigue siendo objeto de controversias.

La teoría cuántica fue desarrollada en su forma básica a lo largo de la primera mitad del siglo XX. El hecho de que la energía se intercambie de forma discreta se puso de relieve por hechos experimentales como los siguientes, inexplicables con las herramientas teóricas "anteriores" de la mecánica clásica o la electrodinámica:

Espectro de la radiación del cuerpo negro, resuelto por Max Planck con la cuantización de la energía. La energía total del cuerpo negro resultó que tomaba valores discretos más que continuos. Este fenómeno se llamó cuantización, y los intervalos posibles más pequeños entre los valores discretos son llamados quanta (singular: quantum, de la palabra latina para cantidad, de ahí el nombre de mecánica cuántica). El tamaño de los cuantos varía de un sistema a otro.

Bajo ciertas condiciones experimentales, los objetos microscópicos como los átomos o los electrones exhiben un comportamiento ondulatorio, como en la interferencia. Bajo otras condiciones, las mismas especies de objetos exhiben un comportamiento corpuscular, de partícula, ("partícula" quiere decir un objeto que puede ser localizado en una región especial del Espacio), como en la dispersión de partículas. Este fenómeno se conoce como dualidad onda-partícula.

Las propiedades físicas de objetos con historias relacionadas pueden ser correlacionadas en una amplitud prohibida por cualquier teoría clásica, en una amplitud tal que sólo pueden ser descritos con precisión si nos referimos a ambos a la vez. Este fenómeno es llamado entrelazamiento cuántico y la desigualdad de Bell describe su diferencia con la correlación ordinaria. Las medidas de las violaciones de la desigualdad de Bell fueron de las mayores comprobaciones de la mecánica cuántica.

Explicación del efecto fotoeléctrico, dada por Albert Einstein, en que volvió a aparecer esa "misteriosa" necesidad de cuantizar la energía.

.

Efecto Compton.

.

El desarrollo formal de la teoría fue obra de los esfuerzos conjuntos de muchos y muy buenos físicos y matemáticos de la época como Schrödinger, Heisenberg, Einstein, Dirac, Bohr y Von Neumann entre otros (la lista es larga). Algunos de los aspectos fundamentales de la teoría están siendo aún estudiados activamente. La mecánica cuántica ha sido también adoptada como la teoría subyacente a muchos campos de la física y la química, incluyendo en materia condensada, termodinámica, química cuántica y física de partículas.

Además de esto La mecánica cuántica describe el estado instantáneo de un sistema (estado cuántico) con una función de ondas que codifica la distribución de probabilidad de todas las propiedades medibles, u observables. Algunos observables posibles sobre un sistema dado son la energía, posición, momento y momento angular. La mecánica cuántica no asigna valores definidos a los observables, sino que hace predicciones sobre sus distribuciones de probabilidad. Las propiedades ondulatorias de la materia son explicadas por la interferencia de las funciones de onda.

Estas funciones de onda pueden transformarse con el transcurso del tiempo. Por ejemplo, una partícula moviéndose en el espacio vacío puede ser descrita mediante una función de onda que es un paquete de ondas centrado alrededor de alguna posición media. Según pasa el tiempo, el centro del paquete puede trasladarse, cambiar, de modo que la partícula parece estar localizada más precisamente en otro lugar. La evolución temporal de las funciones de onda es descrita por la Ecuación de Schrödinger.

Algunas funciones de onda describen distribuciones de probabilidad que son constantes en el tiempo. Muchos sistemas que eran tratados dinámicamente en mecánica clásica son descritos mediante tales funciones de onda estáticas. Por ejemplo, un electrón en un átomo sin excitar se dibuja clásicamente como una partícula que rodea el núcleo, mientras que en mecánica cuántica es descrito por una nube de probabilidad estática, esférico simétrica, que rodea al núcleo.

Cuando se realiza una medición en un observable del sistema, la función de ondas se convierte en una del conjunto de las funciones llamadas funciones propias, estados propios, eigen-estados...etc del observable en cuestión. Este proceso es conocido como colapso de la función de onda. Las probabilidades relativas de ese colapso sobre alguno de los estados propios posibles es descrita por la función de onda instantánea justo antes de la reducción. Considerando el ejemplo anterior sobre la partícula en el vacío, si se mide la posición de la misma, se obtendrá un valor aleatorio x. En general, es imposible predecir con precisión qué valor de x se obtendrá, aunque es probable que se obtenga uno cercano al centro del paquete de ondas, donde la amplitud de la función de onda es grande. Después de que se ha hecho la medida, la función de onda de la partícula colapsa y se reduce a una que esté muy concentrada en torno a la posición observada x.

La ecuación de Schrödinger es determinista en el sentido de que, dada una función de onda a un tiempo inicial dado, la ecuación suministra una predicción concreta de qué función tendremos en cualquier tiempo posterior. Durante una medida, el eigen-estado al cual colapsa la función es probabilista, no determinista. Así que la naturaleza probabilista de la mecánica cuántica nace del acto de la medida.

.

Formulación matemática:

.

En la formulación matemática rigurosa, desarrollada por Dirac y von Neumann, los estados posibles de un sistema cuántico están representados por vectores unitarios llamados (estados) que pertenecen a un Espacio de Hilbert complejo separable (llamado el espacio de estados). La naturaleza exacta de este espacio depende del sistema; por ejemplo, el espacio de estados para los estados de posición y momento es el espacio de funciones de cuadrado integrable. La evolución temporal de un estado cuántico queda descrito por la Ecuación de Schrödinger, en la que el Hamiltoniano, el operador correspondiente a la energía total del sistema, tiene un papel central.

Cada observable queda representado por un operador lineal Hermítico densamente definido actuando sobre el espacio de estados. Cada estado propio de un observable corresponde a un eigenvector del operador, y el valor propio o eigenvalor asociado corresponde al valor del observable en aquel estado propio. Es el espectro del operador es discreto, el observable sólo puede dar un valor entre los eigenvalores discretos. Durante una medida, la probabilidad de que un sistema colapse a uno de los eigenestados viene dada por el cuadrado del valor absoluto del producto interior entre el estado propio o auto-estado (que podemos conocer teóricamente antes de medir) y el vector estado del sistema antes de la medida. Podemos así encontrar la distribución de probabilidad de un observable en un estado dado computando la descomposición espectral del operador correspondiente. El principio de incertidumbre de Heisenberg se representa por la aseveración de que los operadores correspondientes a ciertos observables no conmutan.

.

La teoría cuántica de campos

Sin embargo, quedaba la dualidad campo-partícula, equivalente a la dualidad mecánica-electromagnetismo clásicos que tanto preocupó a Einstein hasta su muerte. Dicha dualidad se levantó a partir de la segunda mitad de la década del 40. Se postuló que las partículas también son campos, naciendo así la teoría cuántica de campos. El primer éxito fue la electrodinámica cuántica, que pudo describir un pequeñísimo efecto medido por esos años con una precisión muy grande. Sin embargo, el problema es difícil y hay que proceder por aproximaciones sucesivas basadas en el hecho de que la interacción electromagnética es suficientemente débil, pero todavía quedan problemas matemáticos graves. Mientras tanto se habían descubierto otras dos interacciones además de las conocidas gravitatoria y electromagnética: la fuerte entre los nucleones componentes del núcleo atómico (protones y neutrones) y la débil asociada con la desintegración de núcleos con emisión de electrones o positrones. Estas también se tratan con la teoría cuántica de campos aunque todavía no con tanto éxito como la electromagnética debido a problemas matemáticos y al poco conocimiento que aún se tiene de ellas (no hay una ley como la de Newton para la gravitación o la de Coulomb para la electricidad). Mientras tanto se fueron descubriendo numerosas partículas elementales, algunas de masas intermedia ente la del electrón y la del protón (que fueron llamadas genéricamente mesones) y otras de masas mayores que la del protón. También se fueron descubriendo las correspondientes antipartículas. Una antipartícula tiene la propiedad de que al encontrarse con su partícula se aniquilan ambas con producción de energía radiante. Así, el positrón predicho por Dirac es el antielectrón. Estas partículas nuevas se crean en colisiones de muy alta energía; de hecho, para crear una partícula se requiere una energía igual al producto de su masa por el cuadrado de la velocidad de la luz de acuerdo con la equivalencia masa-energía descubierta por Einstein. Esta es la razón de que se hayan desarrollado los grandes aceleradores. Por ahora se está buscando un tratamiento unificado de todas esas partículas. Para ello se han introducido nuevas propiedades fundamentales además de la masa, la carga y el espín, las cuales han recibido curiosos nombres como "color" o "encanto". La única partícula que aún se resiste a ser descubierta es el gravitón, es decir, el cuanto del campo gravitatorio. Cuando se lo descubra quedará abierto el camino para la Gran Teoría Unificada, el gran sueño que Einstein no pudo cumplir porque se apartó del camino correcto: el cuántico

.

Simetrías

.

Otro campo de trabajo moderno en la mecánica cuántica es el estudio de las simetrías. La simetría ha preocupado al hombre desde tiempos lejanos. Prueba de ello son los motivos repetitivos en antiguos templos chinos o aztecas, en las vasijas de muchos indios de América y aún en los dibujos del pintor contemporáneo M.C. Escher y de los papeles para cubrir paredes. Los cristales están caracterizados por sus simetrías: se transforman en sí mismos (permanecen invariables) si se realizan ciertas traslaciones a rotaciones. Las moléculas tienen también simetrías, hecho que se viene* estudiando desde que Louis Pasteur (que era cristalógrafo) descubrió que los ácidos tartárico y racémico diferían únicamente en la simetría. En la física se estudian simetrías más profundas que las simplemente espaciales que se han mencionado. Están relacionadas con la invariancia de las leyes fundamentales frente a ciertas operaciones. Así, el principio de relatividad de Galileo y el de Einstein, son principios de simetría. Hasta Einstein, primero se construían las teorías y luego se estudiaban las simetrías y las correspondientes leyes de conservación. Es realmente afortunado que el principio de conservación de la energía, tan caro a toda la ciencia, se verificara en las teorías sin haberlo impuesto explícitamente de antemano. Einstein inaugura una nueva forma de trabajo: partir de postulados de simetría. Este es el enfoque que se ha utilizado sistemáticamente en la teoría cuántica de campos. Es un enfoque profundo y además necesario por cuanto las analogías clásicas ya no sirven para construir los operadores que representan propiedades o variables dinámicas de las partículas.

.

Las leyes de la causalidad y el principio de complementariedad.

.

Elprincipio de incertidumbre. En la Mecánica clásica, el estado instantáneo de un sistema mecánico queda determinadopor los valores de ciertas variables observables (por ejemplo, la posición y la cantidadde movimiento en el caso de una partícula moviéndose a lo largo de una recta). La medidade un observable A es una operación física bien definida, el valor de A, que proporcionaun numero real. La evolución temporal del sistema está regida por la función de Hamilton del mismo, que es una función conocida de los observables y por tanto se puede, al menos teóricamente, predecir con exactitud esa evolución temporal. La definición clásica del estado de un sistema mecánico, presupone tácitamente que:

.

1.- Las variables observables tienen valores precisos, bien definidos en cada instante.

2.- Siempre es posible, al menos en principio, medir dichos valores sin perturbar apreciablemente el sistema. Obviamente, las limitaciones de los instrumentos de medición y de los propios experimentadores hacen que (a) no se cumpla en la practica, pero se admite que los valores de la variables observables se pueden conocer con tanta precisión como se quiera. Por otro lado, en cuanto a (b), la interpretación clásica admite que la interacción entre el fenómeno observado y los aparatos de medida se puede distinguir claramente mediante un análisis conceptual adecuado, de modo que se pueda deducir la perturbación realizada al medir, lo que proporciona una (teóricamente) completa y exacta descripción del fenómeno observado. Como consecuencia de este análisis, el principio de causalidad debe entenderse en el sentido de que se puede predecir el estado futuro de un sistema físico con una probabilidad p tan próxima a 1 como se quiera, mediante un análisis suficientemente elaborado del fenómeno observado. Pues bien, la Mecánica cuántica, en su formulación más ampliamente aceptada, niega la validez general de las hipótesis (1) y (2) y, en consecuencia, el principio de causalidad.

.

La Mecánica Ondulatoria:

.

Al mismo tiempo que la mecanica de matrices, que trata de establecer un modelomatemático de la mecánica cuántica a partir de la mecánica clásica de partículas, surgeotro formalismo matemático, cuyo punto de partida es considerar el átomo como un sistemade vibraciones, en lugar de un sistema mecánico. Como eminente precursor de esta postura, podemos citar a Sir William Rowan Hamilton, quien ya en 1833 propuso la determinación de una única ley de la naturaleza (omodelo matemático) que gobernara tanto la propagación de la luz como el movimiento delas partículas. El descubrimiento posterior de los rayos X, los fenómenos de difracción deelectrones, el efecto fotoeléctrico, etc. contribuyeron a realzar cada vez mas el problemade la dualidad onda-partícula en los fenómenos subatómicos.

El iniciador de la teoría de la mecánica ondulatoria, fue Louis de Broglie, quien siemprehabía estado preocupado por estos fenómenos. Desde sus primeros trabajos sobre la teoríade los cuantos de luz, había sugerido la idea de asociar a los cuantos (partículas) uncierto elemento de periodicidad. Es en su trabajo Ondes et quanta, publicado en lasComptes Rendus en 1923, donde presenta su idea de onda de fase asociada a una partícula, completando así la dualidad onda-corpúsculo. Al describir el movimiento de una partículasometida a un fenómeno paródico interno, con respecto a un observador en reposo, deBroglie introdujo una onda ficticia asociada al movimiento del móvil, y probo que si alcomienzo del movimiento el fenómeno interno de la partícula está en fase con la onda, esta armonía de fase debe persistir siempre para que el movimiento sea estable.

De este hechodedujo que, por ejemplo, en el caso de un electrón moviéndose en una ´orbita alrededor del núcleo, debe haber un número exacto de longitudes de onda que cubran la ´orbita, de loque resulta la condición de cubanización de Sommerfeld. Dedujo también que la partículasigue en cada punto de su trayectoria el rayo de su onda de fase. Ası, si la partículatiene que atravesar una abertura de dimensiones comparables a la longitud de onda dela onda de fase, su trayectoria deberá curvarse de acuerdo con la difracción de la ondade fase. De esta manera, de Broglie reconcilio los fenómenos de difracción e interferenciacon la hipótesis de la naturaleza corpuscular de la luz. Siguiendo este razonamiento, “unchorro de electrones que pase a través de un agujero suficientemente pequeño, deberáexhibir también fenómenos de difracción.”, lo que fue confirmado experimentalmente pocodespués.

La hipótesis de de Broglie que cada partícula tiene una onda asociada fue el punto departida para la elaboración de una nueva teoría de la mecánica. Si hay ondas, se decía, debehaber una ecuación de ondas. Lo que faltaba era descubrir esa ecuacion. Y ese fue el granlogro de Erwin Schrodinger, a la sazon profesor en la Universidad de Zurich, interesado enlo que llamaba la teoría ondulatoria de Einstein-de Broglie, segun la cual un corpúsculomóvil no es mas que la espuma de una radiación ondulatoria... Profundo conocedor de los métodos de auto valores en ecuaciones con condiciones de contorno, por sus trabajos sobrela física de medios continuos, aplica su experiencia al problema y llega a la conclusión deque los niveles de energía posibles de una partícula tienen la apariencia de los auto valoresde un cierto operador. En su monumental trabajo Quantisierung als Eigenwertproblem, publicado en cuatro comunicaciones en Annalen der Physik, a lo largo de 1926, Schrodingerintrodujo su famosa ecuación de ondas, desarrollando un formalismo matemático clásico (en términos de ecuaciones diferenciales) que permita interpretar los fenómenos cuánticos sin apelar a extraños fenómenos discontinuos o saltos cuánticos.

.

La mecánica cuántica y el principio de incertidumbre:

.

El descubrimiento de de Broglie acerca de la naturaleza ondulatoria de las partículas lleva asociado un fenómeno nuevo, que en el mundo clásico del sentido común, resulta sorprendente y en principio antiintuitivo.

Fue Werner Heisenberg (1901-1976) quien llegó a él, pero de una forma totalmente distinta. Hasta ese momento, el desarrollo de la física cuántica mezclaba la física clásica, con el añadido de postulados cuánticos, fruto de resultados experimentales. Sin embargo, un entendimiento total de la naturaleza requiere una teoría más amplia, de la que se deduzcan estos postulados; hay que desarrollar una mecánica cuántica.

La mecánica clásica parte de las tres leyes de Newton. A partir de ellas, es posible describir cualquier situación, y llegar a una ecuación de movimiento, es decir, una ecuación que al resolverla se obtiene la evolución en el tiempo del sistema estudiado. Es un sistema que vale tanto para describir la oscilación de un muelle, como la órbita de un planeta alrededor del Sol.

La mecánica cuántica trata de hacer exactamente lo mismo: partir de un punto común que sea capaz de describir la evolución de cualquier sistema a nivel cuántico. En vez de tratar cada sistema de forma particular (efecto fotoeléctrico, efecto compton, difracción de electrones, el modelo de Bohr para las órbitas), se trata de obtener el comportamiento de cualquier sistema general partiendo de unas ciertas bases.

En el desarrollo de esta mecánica, Heisenberg llegó a un resultado matemático bastante sorprendente. El desarrollo incluía unas operaciones matemáticas que representan la observación experimental del sistema. El resultado fue que si se hacían dos observaciones, por ejemplo de la posición y el momento cinético, el orden en que se hace influye en el resultado final. Matemáticamente, si se hace una observación A, y otra B, esto quería decir que A•B es distinto de B•A. De hecho, su diferencia (A•B - B•A) es un número complejo. Este resultado ocurre sólo para determinadas cantidades relacionadas, como la posición y el momento, o la energía y el tiempo.

.

CAPÍTULO II

Historia de la mecánica cuántica.

.

La mecánica cuántica es la última de las grandes ramas de la física en aparecer. Lo extraordinario es que se desarrolla en unos 30 años adquiriendo prácticamente su forma actual en la segunda mitad de la década del 20. Esto contrasta con la mecánica que puede decirse se inició con Arquímedes doscientos años antes de nuestra era, se desarrolló lentamente durante la Edad Media, nace realmente en el siglo XVII con los trabajos de Galileo Galilei e Isaac Newton, y alcanza su esplendor en los primeros años del siglo XIX, dominando la filosofía como sólo Aristóteles lo había logrado en los casi veinte siglos que precedieron a Galileo. Tiene la importancia de que en su seno nace el método científico. La segunda rama a desarrollarse fue el electromagnetismo en el siglo XIX, aunque ya en el siglo XIII Petrus Peregrinus, un precursor de la investigación experimental, se había ocupado de los imanes, dando origen a los experimentos y teoría desarrollados por William Gilbert en 1600. En la primera mitad del siglo XIX, Faraday unificó electricidad y magnetismo y James Clerk Maxwell logró en 1873 la formulación actual del electromagnetismo. Albert Einstein la completó en 1905 con las correspondientes leyes de movimiento en lo que se conoce como teoría especial de la relatividad, demostrando además que el electromagnetismo era una teoría esencialmente no mecánica. Culminaba así lo que se ha dado en llamar física clásica, es decir, no cuántica. Merece mencionarse un capítulo especial desarrollado en la segunda mitad del siglo XIX: la mecánica estadística; con ella se logró explicar, mediante el uso de métodos estadísticos en conjunción con las leyes de la mecánica, las leyes esencialmente descriptivas de la termodinámica y dar cuenta de numerosos hechos asociados con sistemas de muchos componentes. Ninguno de estos desarrollos es una simple "abstracción" de los datos, aunque Newton, influido de Francis Bacon, lo creyera así.

Fue precisamente en el seno de la mecánica estadística donde nacen las ideas cuánticas. En 1900, Max Planck, para poder explicar la distribución estadística de frecuencias de la radiación emitida por un cuerpo negro, enuncia la hipótesis de que la radiación electromagnética es absorbida y emitida por la materia en forma de cuantos de energía definida proporcional a su frecuencia; la constante de proporcionalidad se denomina constante de Planck y es de fundamental importancia en la mecánica cuántica. Es probable que la idea de Planck hubiera quedado muchos años como hipótesis ad hoc si Einstein no la hubiera retomado, proponiendo que la luz, en ciertas circunstancias, se debe tratar como un conjunto de partículas independientes de energía (los cuantos de luz o fotones) que se comportan como las partículas de un gas. Usó este punto de vista heurístico (como él mismo lo llamó) para desarrollar su teoría del efecto fotoeléctrico (emisión de cargas por efecto de la radiación, tan usada actualmente en dispositivos de control). Publicó esta teoría en 1905 y le valió el Premio Nobel en 1921. La aplicó también para dar una teoría del calor específico (la cantidad de calor necesaria para aumentar en una unidad la temperatura de la unidad de masa de un cuerpo). Con ella no sólo resolvió problemas que se habían presentado durante el siglo XIX sino que predijo nuevos hechos que se verificaron experimentalmente entre 1910 y 1911.

En 1913, Lord Ernest Rutherford descubre experimentalmente que la carga del átomo está concentrada en un núcleo cuyo tamaño es miles de veces menor que el del átomo. El mismo año Niels Bohr propone su modelo planetario cuántico del átomo: los electrones describen alrededor del núcleo órbitas determinadas, es decir cuantizadas, con la hipótesis ad hoc de que en las mismas no emiten radiación tal como se esperaría de la teoría electromagnética. La teoría tuvo gran éxito para explicar las frecuencias de radiación características de cada elemento, que hoy se usan para determinar con extraordinaria precisión la composición química de materiales. Pero no era una teoría fundamental y se le tuvieron que agregar hipótesis ad hoc para acomodar nuevos datos experimentales.

Mientras tanto, Einstein se había dedicado a su famosa teoría general de la relatividad y retoma sus estudios cuánticos a principio de la década del 20, proveyendo una demostración correcta de la ley de Planck. En 1924 apoyó decididamente un nuevo método estadístico propuesto por el joven físico hindú S.N. Bose y lo aplicó a un gas de partícula materiales, conocido hoy como gas de Bose-Einstein, con nuevas e interesantes propiedades que muchos años después se encontraron experimentalmente en el helio a bajísimas temperaturas (del orden de –270ºC). Por esa época conoce la tesis doctoral de Louis de Broglie en la cual se propone que cada partícula material tiene una longitud de onda asociada inversamente proporcional a su momentum (su masa por su velocidad, concepto introducido por Newton y fundamental en la mecánica). Einstein se sintió atrapado por esa idea porque transportaba al campo de la materia su idea de la dualidad onda-partícula y llegó a sugerir diversas posibilidades experimentales para demostrar la existencia de estas ondas materiales. De hecho, la confirmación vino exactamente de los mismos experimentos diseñados para demostrar la naturaleza ondulatoria de los rayos X. Y misteriosa y trágicamente, éste es el último apoyo que las ideas cuánticas recibieron de uno de los más grandes genios de la humanidad. El oponerse a la nueva mecánica cuántica le granjeó la total soledad científica hasta su muerte en 1955. Sin embargo sus ideas gobernaron, consciente o inconscientemente, desarrollos de la mecánica cuántica en las décadas de los 40 y 50, y perduran hasta el presente en las teorías de la gran unificación de las fuerzas fundamentales de la naturaleza que están actualmente en desarrollo, aunque, curiosamente, es la gravitación que tanto ocupó a Einstein la que se "resiste" a ser unificada.

Resumiendo la situación hasta 1925, Einstein había demostrado con su teoría especial de la relatividad que el electromagnetismo no podía tener una interpretación mecánica como se había creído, lo cual implicaba una dualidad en la naturaleza: por un lado lo mecánico y por otro lo electromagnético. El mismo apoyó la dualidad inversa: partículas que se comportan como ondas. Opinaba que la solución estaba en una teoría de campos que lo abarcaba todo. Esencialmente un campo es un ente que asigna a cada punto del espacio (más correctamente del espacio-tiempo) un número tal como la temperatura o la presión, o un número y una dirección (vector) como pueden serio la fuerza gravitacional o la electromagnética. Einstein trabajó infructuosamente en esta idea hasta su muerte, encarándola desde un punto de vista clásico.

Pero hay que volver a esta breve historia. En 1925 los físicos alemanes Werner Heisenberg y Max Born, junto con el matemático Pascual Jordan proponen la primera formulación de la mecánica cuántica usando métodos algebraicos. Poco después, en 1926, el físico austríaco Erwin Schrödinger propone una formulación en términos del más tradicional cálculo infinitesimal (iniciado por Newton) y él mismo demuestra pocos meses después la equivalencia matemática de las dos formulaciones. En 1928 el veinteañero británico Paul Adrian Maurice Dirac hace una formulación abstracta desde el punto de vista matemático teniendo en cuenta la teoría de la relatividad de Einstein. Esta formulación no sólo contiene como casos particulares los dos desarrollos anteriores, sino que incluye automáticamente una nueva propiedad de las partículas descubierta por esos años, el espín, y que se puede interpretar como un giro de la partícula sobre sí misma como la tierra, aunque este concepto no tiene significado en la mecánica cuántica; se trata de una propiedad estrictamente cuántica que, entre otras cosas, completa la descripción fundamental del magnetismo iniciada por Einstein con su teoría de la relatividad. Aún más, predice la existencia de un electrón positivo, el positrón, que se descubrió experimentalmente pocos años después. Así, con 25 años de tradición y menos de tres años de desarrollo nace una nueva ciencia la mecánica cuántica con su formulación definitiva. Fue un proceso demasiado rápido como para que pudiera ser asimilado, incluso por sus propios creadores, como se verá a continuación.

.

Problemas en la nueva ciencia

.

Los dos primeros problemas que se presentaron fueron: uno, el descubrimiento por Born de que la mecánica cuántica era esencialmente probabilística y el otro, las relaciones de incerteza de Heisenberg. Ambos están relacionados con la idea que se tenía entonces sobre la causalidad en los fenómenos naturales. Baste recordar que la característica más importante de la causalidad es que nada surge de la nada o desaparece en la nada o, equivalentemente, todo acontecimiento es producido por otros acontecimientos anteriores. Esto es muy razonable y cualquier científico estaría dispuesto a aceptarlo. Sin embargo, el éxito clamoroso de la mecánica clásica, y del electromagnetismo después, hicieron surgir la idea de que el concepto de causalidad se hace preciso en un dado contexto únicamente en términos del determinismo físico (Bernays, 1979). Este estaba conectado con la forma matemática de las leyes físicas entonces conocidas. De acuerdo con ellas los valores de las cantidades que caracterizan el estado del sistema están determinadas exactamente para todo tiempo si se las especifica para un dado tiempo inicial. Esto se extrapoló en lo que se podría llamar doctrina determinista, según la cual la evolución de todo el universo estaría determinado en la forma que prescriben las leyes de la mecánica clásica y el electromagnetismo. Incluso se llegó a decir que un ser especialmente dotado (que se llamó demonio de Maxwell) si conociera la posición y el momentum de todas las partículas del universo en un instante dado, podría predecir el comportamiento futuro de todo, incluyendo el ser humano. Pero la nueva teoría decía, esencialmente, que dada una causa, el efecto sólo se puede predecir con cierta probabilidad calculada con las ecuaciones fundamentales de la teoría. Sin embargo, el hecho no era nuevo. En la mecánica estadística, iniciada en la segunda mitad del siglo XIX y continuada por Einstein y Enrico Fermi para incluir las nuevas ideas cuánticas, también había este tipo de causalidad probable. Pero los físicos decían que esto se debía a la imposibilidad práctica de conocer la posición y el momentum de todas las partículas que componen un sistema porque son billones de billones; por eso había que contentarse con usar métodos estadísticos como lo hacen las compañías de seguros.

Es natural, entonces, que el hecho de que la teoría, por sus postulados, fuera esencialmente probabilística, escandalizara a las mentes deterministas de la época. Einstein llegó a decir "estoy convencido de que El no está jugando a los dados" (Einstein, 1926), Las discusiones continuaron por medio siglo. Algunas han servido para aclarar conceptos de la filosofía de la ciencia (p. ej. Yourgrau, 1979), otras han dado lugar a intentos de corregir la mecánica cuántica, como la introducción de "variables ocultas" que restituirían el determinismo clásico a la teoría.

Para discutir mejor las relaciones de Heisenberg y para otras consideraciones posteriores, es conveniente dar una idea de la estructura matemática de la mecánica cuántica. El estado de un microsistema (átomo, electrón, molécula, cte.) se representa mediante un vector en un espacio vectorial cuyas propiedades son una generalización de las del espacio ordinario que conocemos El número de dimensiones de dicho espacio (que puede ser infinito) depende del microsistema en crudo. Las variables dinámicas (posición, momentum, energía, etc.) se representan por operadores especiales que actúan en ese espacio. Un operador es esencialmente una operación, por ejemplo, "sumar 3" o "dividir por 3". El álgebra de operadores es casi igual al álgebra elemental con una importante diferencia: el producto puede no ser conmutativo de modo que operar en un cierto orden puede no ser lo mismo que operar en sentido inverso, como en los ejemplos citados. Cuando un operador actúa sobe un vector de estado se obtiene otro vector de estado en el mismo espacio. Si ocurre que ese otro estado es proporcional a aquél sobre el cual se operó, se dice que es un autoestado del operador y que la constante de proporcionalidad es el autovalor correspondiente del operador. El valor numérico de los autovalores de un operador es lo que eventualmente se comparará con los datos experimentales. El cálculo de los autovalores del operador energía para el átomo de hidrógeno fue el primer éxito resonante de la mecánica cuántica pues dieron cuenta de las frecuencias de radiación emitidas por dicho átomo que entonces estaban medidas con gran precisión. Se encontró que bastaba un número finito de operadores que conmutan entre sí para caracterizar un microsistema. Este conjunto es completo en el sentido de que un operador adicional no conmuta con los anteriores.

Se considerarán ahora las relaciones de Heisenberg. Existe un teorema matemático general que dice que el producto de las dispersiones estadísticas de dos operadores que no conmutan es mayor que cierto número que depende de los operadores en cuestión. Las dispersiones se calculan conforme a la definición elemental; la forma de calcularlas depende del campo de aplicación. Hay que insistir que se trata de un teorema matemático que nada tiene que ver con la mecánica cuántica. Heisenberg demostró este teorema para el caso de dos operadores importantes: el momentum y la posición, los cuales no conmutan. La importancia de estas variables dinámicas es que en mecánica clásica su conocimiento preciso permite determinar exactamente el estado de un sistema (basta conocerlos en un instante inicial). Es imaginable el asombro que provocó en los físicos de entonces el hecho de que el momentum y la posición no se pudieran determinar simultáneamente con toda la precisión que se quisiera. Para los físicos contemporáneos, quienes en su mayoría saben más mecánica cuántica que mecánica clásica, el hecho sólo significa que como los operadores momentum y posición no conmutan, no se pueden usar simultáneamente para describir un microsistema. Y esto es lo que dicen los postulados fundamentales de la mecánica cuántica, que sólo se aplica a electrones, núcleos y cosas parecidas y no a planetas, ladrillos y cosas parecidas. Lamentablemente las relaciones de Heisenberg recibieron el nombre de "relaciones de incerteza", el cual es de contenido netamente sicológico. Algunos las elevaron de categoría llamándolas "principio de indeterminación" y de ahí que ciertos comentadores (deterministas por supuesto) llegaron a la conclusión de que la mecánica cuántica contradice el principio de causalidad. Otros la llevaron a campos de la ciencia distintos de la física desprovistas de su contexto, dando lugar a opiniones como "Pero las ciencias duras del siglo XX ya no son tan duras: desde el principio de incertidumbre de Heisenberg las ex leyes físicas son unas constataciones estadísticas de repeticiones de frecuencia" (Imaz, 1988). De todas maneras, las discusiones sobre las relaciones de Heisenberg y la no conmutación de operadores en la física cuántica continuaron y sirvieron para aclarar la filosofía de la nueva ciencia. Baste mencionar que en 1977 se realizó en Munich un congreso en homenaje a Heisenberg que se denominó "Pensamiento y despensamiento en la obra de Heisenberg", y también un trabajo de James L. Park y Henry Margenau (Park, 1979) el cual tiene el defecto que usa una terminología tradicional que llevó a confusiones, de la cual se hablará a continuación.

El tercer problema que ha confrontado la mecánica cuántica es el uso de la interpretación de su formulismo matemático. La primera que apareció y que aún figura en la mayoría de los textos se conoce con el nombre de doctrina de Copenhagen y fue elaborada por los grandes que construyeron la teoría: Bohr, Heisenberg, Born, Dirac y el matemático John von Neumann, quien elaboró un formalismo alternativo al de Dirac por razones que se mencionan más adelante. El nombre proviene de la vinculación de todos ellos con el Instituto de Física de esa ciudad que el gobierno danés había ofrecido a Bohr con motivo de su Premio Nobel en 1922. Mario Bunge ha hecho una excelente crítica a dicha doctrina (v. p. ej. Bunge, 1967a, b) como preparación a su formulación de la mecánica cuántica conforme a los rasgos generales de la ciencia (Bunge, 1967b, pp. 235-306).

Con referencia a la breve descripción matemática dada más arriba, considérese el siguiente postulado: "Si el sistema se encuentra en un estado que es autoestado del operador que representa una de sus propiedades, entonces el valor numérico de esa propiedad es el autovalor correspondiente a ese autoestado". En la doctrina de Copenhagen el mismo postulado aparece en la forma: "Si el sistema se encuentra en un estado que es autoestado de uno de sus observables correspondiente al autovalor a, entonces cuando el observador mide dicho observable obtiene con certeza el valor a". Como se ve, en dicha doctrina se llama "observable" al operador que representa una propiedad o variable dinámica de un sistema. Se dice que es medible, implicando observable directamente lo cual es falso, y se habla de que un observador obtiene con certeza el valor teórico, que también es falso. En primer lugar, la certeza (de neto contenido sicológico) no es importante en ciencia. En segundo lugar, la observación está totalmente separada de la teoría. En tener lugar, todo resultado experimental está afectado de error y por lo tanto no puede ser igual a un resultado teórico. Finalmente, la aplicación de la mecánica cuántica a sistemas complejos requiere introducir modelos de los mismos cuya validez es limitada, llegando a resultados teóricos que pueden ser bien diferentes de los experimentales, pudiéndose hacer únicamente una confrontación global (conjunto de autovalores) y no de detalle (autovalor por autovalor) como pretende la doctrina de Copenhagen.

La razón de esta terminología de la interpretación de Copenhagen hay que buscarla en la filosofía positivista-subjetivista en boga en la década del 20 que dogmatizaba que la ciencia no se refiere a la realidad sino a la experiencia humana. Dicha interpretación sostiene entonces que no hay entes cuánticos autónomos sino que dependen del observador. Esto contradice la tradición de la ciencia moderna y es contradictorio en sí: "Si cada uno de los átomos de mi cuerpo existe sólo en la medida en que puedo observarlo, entonces yo - un sistema de átomos - no existo, puesto que tengo otras cosas que hacer que observar de continuo a mis constituyentes" (Bunge, 1967a). Esta introducción del observador en la teoría ha sido funesta. En primer lugar porque si bien fue hecho sólo para la mecánica cuántica, la trascendió a través de comentadores dando lugar a expresiones tales como "Por fin se nos ha demostrado que también en los fenómenos físicos la actitud del observador condiciona al objeto observado. Nada más y nada menos - salvadas las distancias - que lo sostenido por ese axioma que creíamos privativo de las ciencias sociales" (Imaz, 1988). Lo que el autor llama axioma es una simple recomendación en toda ciencia: como el observador puede perturbar al objeto observado hay que esforzarse para que ello no ocurra. En segundo lugar porque retrasó la enseñanza de la mecánica cuántica en cursos normales. En la Unión Soviética fue prohibida durante muchos años por subjetiva. En Francia se comenzó a enseñar a nivel básico en todo el país por disposición del gobierno en 1967 (Levy, 1967). De todas maneras llevó a la desesperación a mucho aprendiz de físico que después de aprender la física clásica objetiva tenía que aprender la cuántica subjetiva; y para peor con todo el andamiaje histórico-filosófico-sicológico que se utilizó para construirla. Hermann Bondi (1979) sostiene que clarificando los conceptos básicos se los podría enseñar a niños de nueve años. Quizás sea un poco exagerado pero lo cierto es que la clarificación de las ciencias ha permitido presentarlas cada vez a un nivel más elemental de la enseñanza.

Muchas otras cosas se escribieron, algunas de las cuales aún persisten en los textos. Por ejemplo, se diseñaron experimentos pensados semiclásicos para probar la inconsistencia de la mecánica cuántica o su validez. Bohr formuló en 1925 un principio de correspondencia de alto valor heurístico que establecía ciertas condiciones para las cuales los resultados cuánticos pasarían a los correspondientes clásicos. Posteriormente se lo generalizó incluyendo la inversa en la forma de que a toda cosa clásica correspondería una cuántica. Se llegó a hablar de "reglas canónicas de cuantización" de resultados clásicos (Dirac, 1962, p. 11; Dirac, 1964; Lurié, 1968, pp. 45, 87, 125). Es curioso que en la última referencia, para el caso del electrón libre, se gastan varías páginas para desarrollar las fórmulas a cuantizar y otras varias para verificar el fracaso de la regla de cuantización. En realidad, la única regla conocida para construir cualquier teoría (no sólo la mecánica cuántica) es: "No hay rejas para construir teorías". De todas maneras, las analogías clásicas han tenido un gran valor heurístico en el desarrollo de la mecánica cuántica. Es un hecho conocido que la analogía es una fuente de generación de hipótesis.

Puede parecer extraño que los grandes físicos escribieran tantas cosas inútiles o erróneas. Para explicado, en primer lugar hay que recordar que un físico es un hombre y como tal, según dijera José Ortega y Gasset, es él y su contexto. En la década del 20 el contexto era un positivismo subjetivista y un alto desarrollo de la física clásica. En segundo lugar, había que demostrar que se trataba de algo totalmente nuevo y la doctrina de Copenhagen lo consiguió. Lo malo es que los que siguieron adoptaron inconscientemente la actitud acientífica de tomarla como dogma. Pareciera que esto es una actitud de los que siguen a los genios, pues ya Galileo se quejaba del dogmatismo de los peripatéticos, los seguidores de Aristóteles.

.

Influencia de la mecánica cuántica en la historia:

.

Durante esta época en la cual se descubre la mecánica cuántica, no solo hubo una gran revolución en el campo de la ciencia, pero también el mundo estaba pasando por grandes cambios históricos como la revolución rusa, la primera y segunda guerras mundiales. Las consecuencias de la mecánica cuántica podrían haber completamente cambiado el mundo tal como lo conocemos ahora. Una de las consecuencias casi inmediatas de la mecánica cuántica es que ciertos átomos como el Uranio-235 se pueden fisionar (“quebrar”) si un neutrón (una partícula subatómica) choca con el. Cuando esto ocurre, se liberan un gran cantidad de energía y dos neutrones. En turno cada uno de estos neutrones choca con otro átomo de Uranio-235, libera energía y dos neutrones más. Esto es lo que se llama una “reacción en cadena” y da origen a una terrible arma: la bomba atómica. El único problema para construir una bomba atómica es que el uranio tiene varias formas (isótopos). El más abundante en la naturaleza es el Uranio-238 que no es fisionable y el Uranio fisionable (U-235) es solo 0.7% del Uranio que ocurre en la naturaleza. Separar el U-235 de los otros isótopos del Uranio es una tarea monumental. Y la principal dificultad para construir La Bomba.

Pero no todo la influencia de la mecánica cuántica fue de carácter destructivo ya que se lograron mas cosas como el avance de la medicina, con la infinidad de instrumentos nuevos que permiten diagnósticos y tratamientos mucho más simples y precisos. Baste mencionar aquí el láser, el scanner, los equipos de resonancia magnética nuclear, los rayos X, etc. todos los cuales no existirían sin este conocimiento básico.

El transistor, inventado en la primera compañía de teléfonos, Bell Telephone, ciertamente es el invento más importante del siglo XX. Basado en el trabajo de tres físicos de sólidos, Bardeen, Brattain y Shockley, el transistor reemplazó los tubos. Su gran aporte fue la posibilidad de la miniaturización de la electrónica. Esto dio origen a los llamados circuitos integrados. Actualmente estos dispositivos están virtualmente en todos los aparatos y maquinarias que nos rodean: automóviles, aviones, cocina, computadores, medicina, sensores, controles industriales, etc., y ciertamente son esenciales en las telecomunicaciones a través de teléfonos, radio y televisión. Probablemente 99% de la industria moderna y 100% de las telecomunicaciones están impactadas por la invención del transistor. El mundo moderno, sin estos dispositivos, es inimaginable. Por el descubrimiento del efecto del transistor Bardeen, Brattain y Schockley recibieron el premio de Nobel en Física el año 1956.

El láser, junto con la fibra óptica, han aumentado el volumen de comunicaciones posibles y han mejorado enormemente la calidad de la transmisión. Inicialmente, las señales telefónicas se transmitían a través de cables metálicos. Hoy, con la invención de la fibra óptica y del láser, es posible transmitir en el mismo volumen de cables, millones de señales telefónicas más de lo que era posible anteriormente. También, gracias a que las comunicaciones son digitales, la calidad de la señal es enormemente superior, lo que permite, por ejemplo, la transmisión de señales de alta calidad acústica.

El impacto de la Física del Sólido en el futuro se esta vislumbrando también por descubrimientos e investigaciones basadas la Mecánica Cuántica. Uno de los temas de más intensa investigación actual es el de la llamada Spintrónica. Esta técnica posiblemente dará origen a toda una nueva electrónica digital. Hasta ahora la electrónica estaba basada en la carga eléctrica del electrón. Sin embargo otra propiedad fundamental del electrón, el llamado spin, no ha sido explotada en electrónica. Otro tema de investigación básica es la Computación y Comunicaciones Cuánticas. Una vez más una idea de la ciencia básica tiene implicaciones importantes para el futuro de las comunicaciones seguras, a través de la criptologia (la ciencia que permite enviar mensajes en clave), y la posibilidad de hacer crecer la velocidad de los computadores y de las telecomunicaciones enormemente. A dónde nos llevará esta nueva dirección de investigación básica en Física del Sólido es imposible imaginarse. Tal como hace 30 años hubiera sido imposible imaginar el mundo moderno que nos rodea.

La base de la tecnología moderna es la Mecánica Cuántica aplicada a la Física del Sólido en la cual la escuela de Copenhague de Bohr, Heisenberg, Einstein, Schrödinger jugaron un rol esencial. La obra de teatro Copenhague de Michael Frayn toca íntimamente este tema y discute varios problemas relacionados al desarrollo de la Mecánica Cuántica.

.

La evolución histórica del modelo atómico:

Modelo Atómico de John Dalton:

.

John Dalton, profesor y químico británico, estaba fascinado por el rompecabezas de los elementos. A principios del siglo XIX estudió la forma en que los diversos elementos se combinan entre sí para formar compuestos químicos. Aunque muchos otros científicos, empezando por los antiguos griegos, habían afirmado ya que las unidades más pequeñas de una sustancia eran los átomos, se considera a Dalton como una de las figuras más significativas de la teoría atómica porque la convirtió en algo cuantitativo. Dalton desarrolló un modelo científico y formulo una serie de postulados concernientes a la naturaleza de los átomos, los cuales destacaban la masa como una propiedad atómica fundamental. Basándose en los datos experimentales imperfectos de que disponía, Dalton propuso su teoría por medio de los siguientes postulados:

1. La materia está compuesta por partículas pequeñísimas llamadas átomos.

2. Los átomos son individuales y no pueden transformarse unos en otros.

3. No pueden ser creados ni destruidos.

4. Los elementos se hallan constituidos por átomos. Los átomos de un mismo elemento son idénticos en tamaño, forma, masa y todas las demás cualidades, pero diferentes a los átomos de los otros elementos.

5. Los átomos de unen para formar las moléculas, combinándose en proporciones fijas de números enteros y pequeños. Por ejemplo, un átomo de azufre (S) se combina con dos átomos de oxígeno (O) para formar la molécula SO2, y lo hacen siempre en la relación de 1:2.

6. Dos o más elementos, pueden combinarse de diferentes maneras para formar más de una clase de compuestos. Así, entre el azufre (S) y el oxígeno (O) se pueden formar dos compuestos diferentes, el SO2 y el CO2. En cada uno de estos compuestos hay una proporción de átomos y masa diferente pero definida y siempre en la relación de números enteros y pequeños.

Durante casi un siglo no se dudó de ninguno de los puntos esenciales de la teoría atómica propuesta por Dalton.

.

Modelo Atómico de John Thomson:

Para los científicos de 1900, al tomar como base los experimentos con rayos catódicos, rayos positivos y, en general, la relación entre materia y electricidad, era clara la necesidad de revisar el modelo atómico propuesto por Dalton.

El descubrimiento del electrón realizado por John Thomson, físico británico, así como los llamados rayos canales o rayos positivos, que pueden observarse como un fino haz de luz detrás de un tubo de descarga con el cátodo perforado, llevó a la conclusión de que el átomo no podía ser una esfera rígida de material característico para cada elemento, como había supuesto ingenuamente Dalton, sino que debía poseer una estructura.

Aunque el nuevo modelo atómico explicaba la relación materia y electricidad, faltaban las bases fundamentales de la combinación química explicada por Dalton en su teoría atómica.

El modelo propuesto por Thomson consideraba al átomo como una esfera de masa cargada positivamente y sobre la cual flotan los electrones, exactamente como se encuentran las uvas, pasas o ciruelas sobre un pastel.

.

Modelo Atómico de Ernest Rutherford:

.

Rutherford, científico británico, nacido en Nueva Zelanda estudio de la radioactividad, descubierta a finales del s. XIX, había conducido a la hipótesis de que el número atómico representaba el número de unidades de carga positiva del átomo y, puesto que este es neutro, también el número de electrones. La naturaleza de las distintas radiaciones que emite el radio fue establecida por E. Rutherford en 1903 y, en 1911, el propio Rutherford inició una serie de experimentos cruciales de los que surgió el concepto de núcleo atómico.

En estos experimentos, Rutherford y sus colaboradores H. Geiger y E. Marsden utilizaron una fuente de partículas y, mediante la interposición de planchas de plomo, colimaron el haz de partículas y lo dirigieron sobre una lámina de oro muy fina. Las partículas atravesaron la lámina e incidían sobre una superficie cubierta de sulfuro de zinc, provocando un centelleo. A partir de la observación de este centelleo era posible concluir que la gran mayoría de las partículas atravesaban las láminas sin sufrir, o casi sin sufrir, desviación, mientras que algunas sufrían una desviación considerable e incluso unas pocas no lograban atravesar la lámina, rebotando en ella como una pelota contra una pared. Este resultado contradecía el modelo atómico de Thomson, ya que, en caso de ser ese correcto, las partículas no deberían sufrir diferentes desviaciones. Para explicarlo, Rutherford supuso que toda la carga positiva del átomo estaba concentrada en una región, a la que se dio el nombre de núcleo, cuyo diámetro era una diezmilésima del diámetro del átomo.

Los electrones, orbitando en torno al núcleo, equilibrarían la carga positiva de éste, que estaría representada por partículas denominadas protones, de carga igual y de signo contrario a la de los electrones. La materia está así practicamente vacía, lo que explica que la mayoría de las partículas que incidan en la lámina de oro no se desvíen, mientras que las partículas que pasan cerca del núcleo de un átomo de oro sufren fuertes desviaciones, y las que inciden directamente sobre un núcleo, rebotan.

La casi totalidad de la masa del átomo correspondiente al núcleo, puesto que la masa del protón, según se había determinado experimentalmente, es 1836 veces mayor que la masa del electrón. Como se sabía que el número atómico representa el número de cargas positivas en el núcleo y puesto que el número de protones necesario para obtener las masas de los átomos era superior al número atómico, era preciso suponer que en el núcleo había, además de los protones que se neutralizaban mutuamente de manera que no como cargas, sino sólo aportando masa. Rutherford no se sentía satisfecho con la idea de que en el núcleo también hubiera electrones y en 1920 especuló con la posibilidad de que en el núcleo hubiera otras partículas de masaa similar al protón, pero carentes de carga eléctrica a las que, por esta razón, se denominó neutrones. La existencia de neutrones fue confirmada por J. Chadwick en 1932, cuando identificó como constituida por esas partículas netras la radiación obtenida al bombardear berilio con partículas.

.

Modelo Atómico de Niels Bohr:

.

Niels Bohr, físico danés. Para explicar la estructura del átomo, el físico danés Niels Bohr desarrolló en 1913 una hipótesis conocida como teoría atómica de Bohr. Bohr supuso que los electrones están dispuestos en capas definidas, o niveles cuánticos, a una distancia considerable del núcleo. La disposición de los electrones se denomina configuración electrónica. El número de electrones es igual al número atómico del átomo: el hidrógeno tiene un único electrón orbital, el helio dos y el uranio 92. Las capas electrónicas se superponen de forma regular hasta un máximo de siete, y cada una de ellas puede albergar un determinado número de electrones. La primera capa está completa cuando contiene dos electrones, en la segunda caben un máximo de ocho, y las capas sucesivas pueden contener cantidades cada vez mayores. Ningún átomo existente en la naturaleza tiene la séptima capa llena. Los “últimos” electrones, los más externos o los últimos en añadirse a la estructura del átomo, determinan el comportamiento químico del átomo.

Todos los gases inertes o nobles (helio, neón, argón, criptón, xenón y radón) tienen llena su capa electrónica externa. No se combinan químicamente en la naturaleza, aunque los tres gases nobles más pesados (criptón, xenón y radón) pueden formar compuestos químicos en el laboratorio. Por otra parte, las capas exteriores de los elementos como litio, sodio o potasio sólo contienen un electrón. Estos elementos se combinan con facilidad con otros elementos (transfiriéndoles su electrón más externo) para formar numerosos compuestos químicos. De forma equivalente, a los elementos como el flúor, el cloro o el bromo sólo les falta un electrón para que su capa exterior esté completa. También se combinan con facilidad con otros elementos de los que obtienen electrones.

Las capas atómicas no se llenan necesariamente de electrones de forma consecutiva. Los electrones de los primeros 18 elementos de la tabla periódica se añaden de forma regular, llenando cada capa al máximo antes de iniciar una nueva capa. A partir del elemento decimonoveno, el electrón más externo comienza una nueva capa antes de que se llene por completo la capa anterior. No obstante, se sigue manteniendo una regularidad, ya que los electrones llenan las capas sucesivas con una alternancia que se repite. El resultado es la repetición regular de las propiedades químicas de los átomos, que se corresponde con el orden de los elementos en la tabla periódica.

Resulta cómodo visualizar los electrones que se desplazan alrededor del núcleo como si fueran planetas que giran en torno al Sol. No obstante, esta visión es mucho más sencilla que la que se mantiene actualmente. Ahora se sabe que es imposible determinar exactamente la posición de un electrón en el átomo sin perturbar su posición. Esta incertidumbre se expresa atribuyendo al átomo una forma de nube en la que la posición de un electrón se define según la probabilidad de encontrarlo a una distancia determinada del núcleo. Esta visión del átomo como “nube de probabilidad” ha sustituido al modelo de sistema solar.

.

CAPÍTULO III

Principales autores de la mecánica cuántica.

..

Físico alemán, premiado con el Nobel, considerado el creador de la teoría cuántica, de quién Albert Einstein dijo: "Era un hombre a quien le fue dado aportar al mundo una gran idea creadora". De esa idea creadora nació la física moderna, que intenta saber si "Dios juega o no a los dados", si el azar existe o no.

Como muchas veces suele ocurrir, las primeras inclinaciones intelectuales de Planck no estuvieron orientadas hacia la ciencia, sino que a la filología y la música, pero su profesor Hermann Müller, del Gimnasio Maximiliano, en Munich, le hizo desistir de sus aficiones.

Cuando ingresó en 1874 a la Universidad de Munich, y estudió un año en la Universidad de Berlín, dejó su pasión por los románticos alemanes como Brahms, Schubert y Schumann, para internarse en el laberinto que le abrieron sus profesores Hermann von Helmholtz y Gustav Robert Kirchhoff, quienes realizaron investigaciones que utilizó Planck, en 1900, para proponer su teoría de los cuantos (partículas comparables a un grano de luz), que dividió la física en dos etapas: la clásica, desarrollada en los siglos XVII, XVIII y XIX, y la moderna.

Así, Planck concluía unas investigaciones que comenzó en 1879, cuando hizo su tesis doctoral sobre el segundo principio de la termodinámica (rama de la física que se ocupa de la energía) del físico Sadi Carnot; ideas con las que el alemán Rudolf Clausius planteó su teoría de la entropía (cantidad de energía que se podía convertir en trabajo).

En el año 1880, ocupa su primer cargo académico en la Universidad de Kiel y, cinco años más tarde, es nombrado profesor titular de una de las cátedras de física, y desde 1889 hasta 1928 ocupó el mismo cargo en la Universidad de Berlín. En 1900 Planck formuló que la energía se radia en unidades pequeñas separadas denominadas cuantos. Avanzando en el desarrollo de esta teoría, descubrió una constante de naturaleza universal que se conoce como la constante de Planck. La ley de Planck establece que la energía de cada cuanto es igual a la frecuencia de la radiación multiplicada por la constante universal. Sus descubrimientos, sin embargo, no invalidaron la teoría de que la radiación se propagaba por ondas. Los físicos en la actualidad creen que la radiación electromagnética combina las propiedades de las ondas y de las partículas. Los descubrimientos de Planck, que fueron verificados posteriormente por otros científicos, promovieron el nacimiento de un campo totalmente nuevo de la física, conocido como mecánica cuántica y proporcionaron los cimientos para la investigación en campos como el de la energía atómica.

Durante el proceso en el cual Planck formulaba sus investigaciones, el lenguaje y la teoría necesarios, hoy conocidos como mecánica cuántica, estaban por aquel entonces evolucionando en los institutos de física de Europa. Planck, en sus sustentaciones teóricas, guarda una gran semejanza con las ideas de Goethe: basta una gran vía que permita la búsqueda para explorar todo le explorable, contemplando lo inexplorable. "Lo que se debe interpretar –decía Planck–... debe dirigirse hacia todo lo que sea explorable". Y de su exploración concluyó que el pensamiento causal y el físico son equivalentes.

La casualidad, como las direcciones en las que pueden caer las gotas de agua de una catarata, según un ejemplo del físico rihard feynman podían ser susceptibles de medición, según la teoría del quantum.

El estudio de la distribución de la energía en el campo de influencia de un cuerpo negro resume la teoría de Planck. La energía radiante se emite (el Sol) o absorbe (el cuerpo negro) sólo en múltiplos enteros de un cuanto, cuya magnitud es proporcional a la frecuencia de radiación absorbida o emitida.

Un cuerpo negro es un sistema ideal capaz de absorber toda la radiación que incide sobre él. Planck planteó una ecuación simple que describía la distribución de la irradiación de las variadas frecuencias, basado en una suposición: la energía no es divisible infinitamente; como la materia, está formada de partículas, a las que llamó quantum.

El tamaño de cada quantum, para cada radiación electromagnética, es directamente proporcional a su frecuencia: constante de Planck, que se representa con la h.

Los científicos sabían que el color de la luz que emite un cuerpo –la gama de sus longitudes de onda– está relacionado con el material del que está hecho el objeto y con su temperatura. Hablando en general, la luz azul, con longitudes de onda muy cortas, es la que prevalece en el espectro de los objetos muy calientes; las longitudes de onda rojas, o más largas, indican menos calor. Hay representadas también otras longitudes de onda, pero como regla general, cada temperatura se relaciona con una longitud de onda dominante, que proporciona al objeto resplandeciente un color característico. Para simplificar su análisis de la radiación, los teóricos del siglo XIX habían conjurado el cuerpo negro. Al contrario que los objetos reales, esta entidad imaginaria absorbe la radiación de todas las frecuencias, lo cual la hace completamente negra. También emite radiación de todas las frecuencias, independientemente de su composición material. Los experimentadores habían creado ingeniosos dispositivos para aproximar esta construcción teórica a los laboratorios, y habían aprendido mucho sobre las características de la radiación del cuerpo negro. Lo que les faltaba era una teoría para predecir la distribución o forma del espectro de radiación del cuerpo negro, es decir, la cantidad de radiación emitida a frecuencias específicas a varias temperaturas.

La mayoría de los científicos creían que la clave de este problema se hallaba en comprender la interacción entre radiación electromagnética y materia. En 1900, cuando Planck atacó el problema, aceptó la teoría electromagnética de la luz que sostenía que la luz era un fenómeno ondulatorio y que la materia –que se suponía que contenía pequeños cuerpos cargados eléctricamente, o partículas– irradiaba energía en la forma de ondas de luz cuando esas partículas cargadas eran aceleradas, La sabiduría aceptada decretaba también que la cantidad de energía radiada por una partícula cargada acelerada podía situarse en cualquier parte a lo largo de una gama continua.

Para el propósito de estudiar la radiación de un cuerpo negro, Planck imaginó las partículas cargadas como diminutos osciladores, acelerados y decelerados repetidamente de una forma sencilla, suave y regular, como si estuvieran unidos a un muelle ingrávido. Hasta ese momento, se mantenía firmemente dentro del reino de la física del siglo XIX. Pero a partir de ahí se desvió radicalmente.

En el camino de calcular el equilibrio de energía entre los supuestos osciladores y su radiación de entrada y salida, Planck halló que necesitaba suponer la existencia de quantums, o ciertas pequeñas divisiones de energía, antes que una gama continua de posibles energías. Definió un quantum de energía como la frecuencia de la oscilación multiplicada por un número diminuto que no tardó en ser conocido como la constante de Planck. Luego utilizó estas suposiciones para resolver el problema del cuerpo negro; su solución matemática predijo perfectamente la radiación del espectro del cuerpo negro.

El propio Planck nunca avanzó una interpretación significativa de sus quantums, y aquí quedó el asunto hasta 1905, cuando Einstein, basándose en el trabajo de Planck, publicó su teoría sobre el fenómeno conocido como efecto fotoeléctrico (arriba). Dados los cálculos de Planck, Einstein demostró que las partículas cargadas –que por aquel entonces se suponía que eran electrones– absorbían y emitían energías en cuantos finitos que eran proporcionales a la frecuencia de la luz o radiación. En 1930, los principios cuánticos formarían los fundamentos de la nueva física.

Aunque Planck sostuvo que la explicación era un modelo distinto al verdadero mecanismo de la radiación, Albert Einstein dijo que la cuantización de la energía era un avance en la teoría de la radiación. No obstante, Planck reconoció en 1905 la importancia de las ideas sobre la cuantificación de la radiación electromagnética expuestas por Albert Einstein, con quien colaboró a lo largo de su carrera.